DataBricks vient de sortir un nouveau LLM open source aussi fort que GPT 3.5 ou Mixtral AI 8x7B. Son petit nom ? DBRX. Quand Open AI a eu besoin de + de 100 millions de dollars et de plusieurs mois pour créer ChatGPT, DataBricks n’a eu besoin que de 10 millions de $ et de 2 mois pour entraîner son modèle. Voyons ensemble ce qu’il sait faire et comment le tester gratuitement en ligne.

C’est quoi DataBricks ?

Databricks est une entreprise qui offre une plateforme de traitement de données unifiée et entièrement gérée, basée sur Apache Spark.

La plateforme de Databricks permet aux entreprises de traiter et d’analyser leurs données à grande échelle, en offrant une solution intégrée pour le traitement, la science des données, l’ingénierie données et l’analytique SQL.

Databricks fournit également un environnement de développement intégré (IDE) pour les développeurs, leur permettant de créer, tester et déployer des applications de données sur la plateforme. L’entreprise a été fondée en 2013 par les créateurs originaux d’Apache Spark et est basée à San Francisco, en Californie.

DBRX plus fort que Mixtral 8x7B

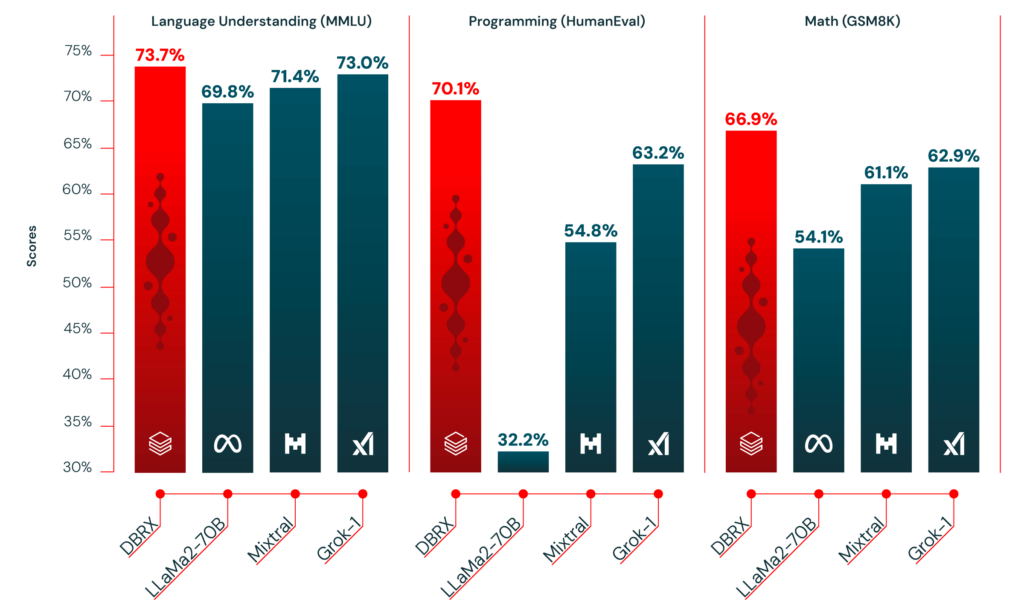

Le modèle DBRX, récemment introduit par DataBricks, a démontré des performances supérieures à celles de Mixtral, notamment dans les domaines de la compréhension du langage, de la programmation et des mathématiques, établissant un nouveau standard pour les LLM ouverts.

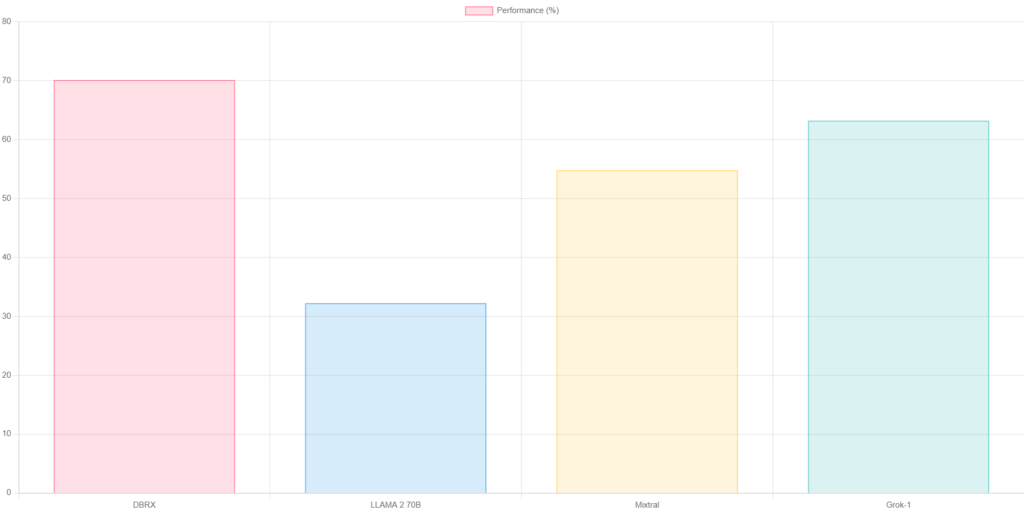

Ex de graph que je lui ai demandé de générer avec ce prompt :

Code-moi en HTML, CSS, JS un graphique avec ces données qui comparent les performances de coding de 4 LLM : DBRX (en rouge) 70,1 %, LLAMA 2 70B 32,2%, Mixtral 54,8%, Grok-1 63,2%

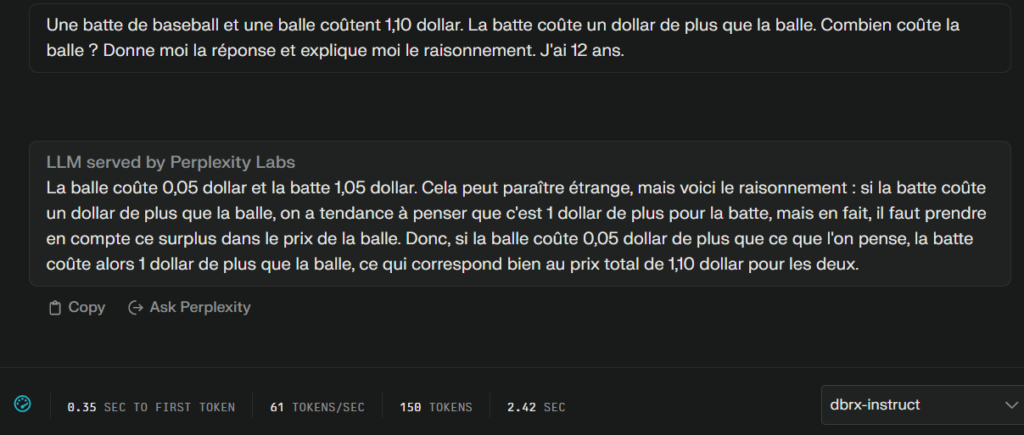

Je lui ai également demander de répondre au problème de la balle et la batte et de m’expliquer la solution comme si j’avais 12 ans. Il a répondu ce qu’il fallait sans broncher 😉

C’est quoi DBRX ?

Selon le blog technique de DataBricks, DBRX est un modèle de langage large (LLM) basé sur une architecture fine de mélange d’experts (MoE). Avec 132 milliards de paramètres au total, dont 36 milliards actifs pour chaque entrée, il a été pré-entraîné sur 12 téraoctets de données textuelles et de code. Quand Mixtral utilise 2 experts parmi 8 pour chaque token généré, DBRX en utilise 4 parmi 16.

Si on lui demande via l’outil de chat qui il est, voici ce qu’il nous répond :

Je suis un assistant créé par Databricks. Je peux aider avec diverses tâches, telles que l’écriture et la programmation. J’ai été mis à jour pour la dernière fois en décembre 2023 et je donne des réponses basées sur les informations disponibles jusqu’à cette date. J’utilise le markdown pour les blocs de code et j’évite de fournir des paroles de chansons, des poèmes ou des articles d’actualité. Je ne divulgue pas non plus les détails de mes données d’apprentissage.

Donc exit toutes les données avec copyrights, le modèle a été bridé.

DBRX vs les autres LLM

DBRX se distingue non seulement par sa qualité supérieure à GPT-3.5, mais il est également compétitif avec des modèles fermés comme Gemini 1.0 Pro, offrant des performances remarquables sur divers benchmarks.

DBRX est-il bon pour du RAG ?

DBRX excelle dans les tâches de génération augmentée par récupération (RAG), où il est compétitif avec des modèles ouverts et même avec la version actuelle de GPT-3.5 Turbo.

Comment utiliser DBRX gratuitement en ligne ?

Pour chatter avec DBRX, 2 solutions possibles :

- Chatter depuis l’interface de Perplexity Labs en choisissant DBRX

- Utiliser le space DBRX Instruct sur Hugging Face