Mistral AI, le ChatGPT made in France et open source, qui n’existait pas il y a encore 1 an, fait le buzz en ce moment. Pourquoi ? Ils viennent de lever 385 millions d’euros et aussi de sortir leur dernier modèle de langage « Mixtral 8x7B » qui rivalise avec Chat GPT 3.5. Dans cet article, nous allons voir ce que cet assistant a de si particulier et comment le tester gratuitement depuis un PC, un Mac, un iPhone ou un Android.

Mistral AI a levé 385 millions d’euros

En France, on a beaucoup parlé de leur levée de fonds de 385 millions d’euros – avec un financement du fond du créateur de Netscape Marc Andreessen – d’il y a 2 semaines qui les valorise à 2 milliards d’euros alors que la boîte n’existait pas il y a encore 1 an au moment on où le monde découvrait tout juste ChatGPT

Leur dernier LLM Mixtral 8x7B bat ChatGPT 3.5

Dans la communauté IA internationale, Mistral AI s’est surtout fait remarquer en sortant 2 large language models légers et performants en moins de 3 mois : Mistral 7B et Mixtral 8x7B.

Et là où ils ont fait très fort c’est que le dernier modèle Mixtral 8x7B bat dans tous les benchmarks ChatGPT 3.5, le modèle de langage le plus populaire au monde.

Pourquoi c’est compliqué de tester Mixtral AI ?

Il n’est pas si facile de le tester un LLM Open Source si on ne connaît pas les bons outils.

Car la particularité de Mistral AI c’est qu’ils ont livré brut de fonderie leurs LLM open source au monde sur X/Twitter via des liens magnet / Torrent.

Et c’est la communauté IA qui a ensuite générer des sous modèles pour qu’on puisse plus facilement les utiliser via des interfaces de chatbot classiques.

C’est quoi au fait Mixtral 8x7B ?

Mistral AI a lancé Mixtral 8x7B, un modèle de mélange d’experts de haute qualité qui est capable de répondre à une question 6x plus vite que Llama 2 70B, le dernier modèle de langage open source de Facebook.

Mixtral se distingue par son rapport coût/performance et sa licence permissive, rivalisant ou surpassant GPT3.5 dans la plupart des benchmarks standards.

Contrairement aux précédents modèles de langages open source, on peut lui parler en plus de l’anglais aussi en français, italien, allemand et espagnol.

Il a un contexte max de 32 000 tokens, soit 16 000 mots quand GPT 3.5 se limite à 2 000 mots. Ca veut dire qu’il ne perdra pas souvent la mémoire quand tu lui parles et que tu peux lui soumettre des larges quantités de documents en entrée.

C’est quoi Mixture of experts ?

L’architecture Mixture of experts est la même que celle utilisée par GPT4. Pour vulgariser le concept, c’est comme si Mixtral avait 8 experts, des réseaux de neurones, spécialisés dans des tâches de maths, codage informatique, français, traduction, raisonnement, etc…

Chaque mot qu’on formule fait appel à 2 experts en même temps et on peut utiliser différents experts pour différents mots.

Pour illustrer le concept, imagine que tu aies en face de toi un humain capable de faire appel à 2 zones du cerveau en même temps une pour comprendre et l’autre pour raisonner et bien si tu lui poses une question, la réponse sera forcément meilleure que si tu lui demandes de répondre intuitivement sans réfléchir.

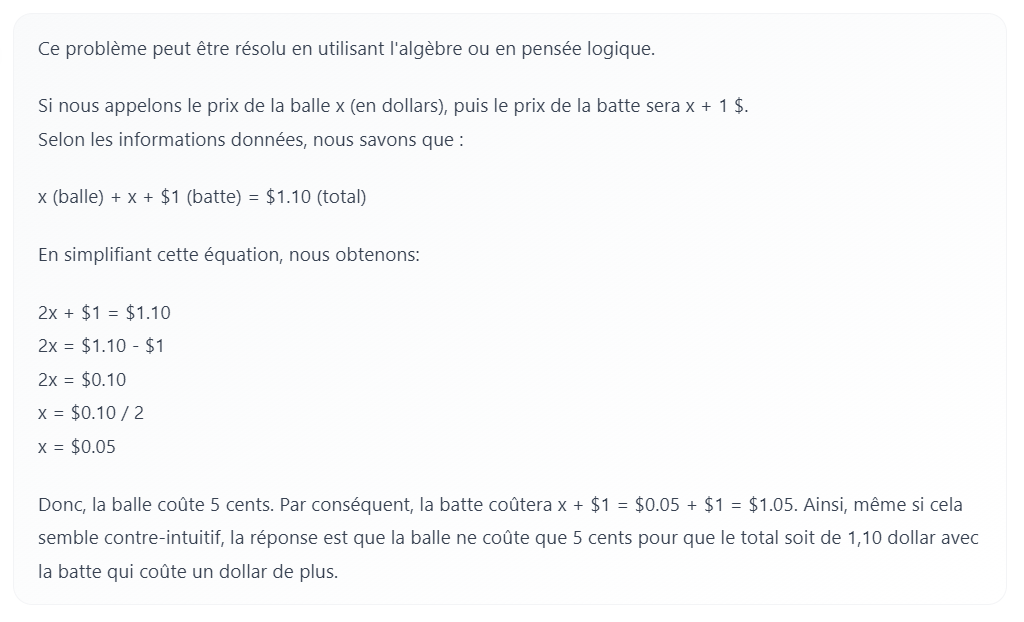

Mixtral AI sait résoudre le problème de la balle et la batte

On peut illustrer ça avec le problème de la balle et la batte qu’on pose souvent aux étudiants dans les grandes universités américaines.

Le problème est formulé ainsi : « Une batte et une balle coûtent 1,10 dollar au total. La batte coûte un dollar de plus que la balle. Combien coûte la balle ? ».

La réponse intuitive, mais incorrecte, est souvent 10 cents, alors que la réponse correcte et réfléchie est 5 cents.

Grâce à l’architecture Mixture of experts, Mixtral AI répondra 5 cents quand les autres LLM open source répondront 10 cents ou n’importe quoi.

Comment tester Mixtral AI en local ou en ligne ?

Pour tester facilement et rapidement Mixtral AI, vous pouvez vous rendre sur HuggingChat et activer le modèle mistralai/Mixtral-8x7B-Instruct-v0.1

Si vous avez un bon PC (avec 32 go de RAM), vous pouvez tester via LM Studio le modèle Mixtral-8x7B-Instruct-v0.1-GGUF créé par TheBloke.

Prenez la version medium mixtral-8x7b-instruct-v0.1.Q4_K_M.gguf pour avoir quelque chose de puissant et rapide.

Un tuto vidéo complet pour tester Mixtral 8x7b

Perdu dans mes explications ? Regarde mon tuto YouTube qui t’explique comment utiliser Mistral AI sur tous tes écrans.

2 réponses sur « Mistral AI : Comment tester le ChatGPT français gratuitement ? »

[…] accès à l’API Mistral AI qui permet de tester tous les modèles de langage que propose Mistral AI : mistral-tiny, mistral-small, […]

[…] Mistral AI, le ChatGPT made in France, est désormais accessible au grand public via une interface web conviviale. Auparavant, l’utilisation de Mistral AI nécessitait une configuration PC importante ou l’utilisation de leur API, ce qui le réservait principalement aux développeurs ou aux gamers. […]