Aujourd’hui, nous allons explorer une nouvelle fonctionnalité révolutionnaire introduite par Opera : l’intégration de modèles de langage locaux (LLM) dans leur navigateur, Opera One. Cette avancée majeure permet aux utilisateurs de traiter leurs requêtes directement sur leur machine, sans avoir à envoyer de données à un serveur. Idéal si on veut garder ses conversations avec l’IA privée.

Comment installer Opera One Developer sur PC et Mac ?

Pour tester cette nouvelle fonctionnalité, vous devez d’abord télécharger la version développeur d’Opera One.

Vous pouvez le faire sur PC Windows en cliquant sur ce lien : https://www.opera.com/fr/computer/thanks?ni=developer&os=windows

Sur Mac OS, ça se passe ici : https://www.opera.com/fr/computer/thanks?ni=developer&os=mac

Une fois le téléchargement terminé, installez le navigateur sur votre ordinateur en suivant les instructions à l’écran.

Comment afficher les options d’IA dans Opera ?

Après avoir installé Opera One Developer, ouvrez le panneau de chat Aria sur le côté.

Pour utiliser les IA d’Opera, il vous faudra la première fois vous créer un compte Opera en indiquant votre email et en validant ensuite la création de ce compte par email.

J’ai été un peu surpris par ce parcours étant donné que la promesse du LLM local vise en principe à rester anonyme.

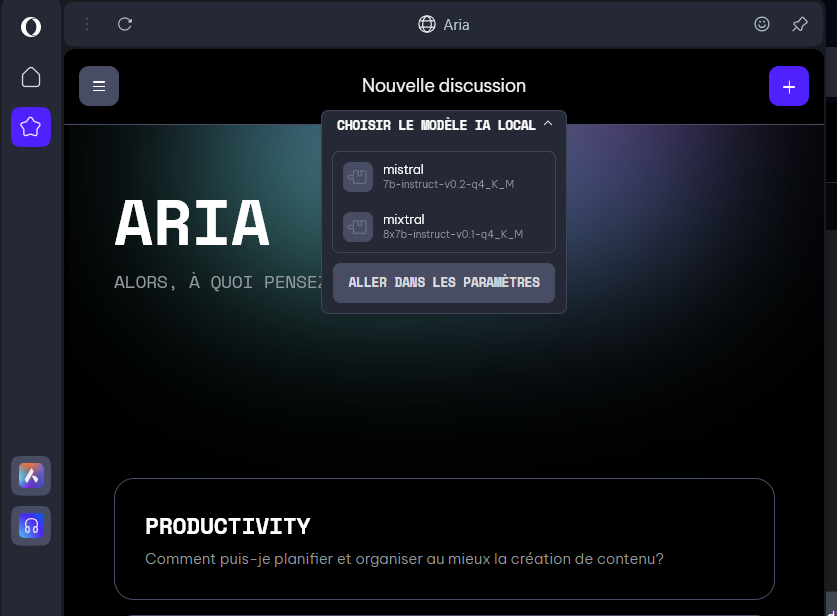

En haut du chat, vous verrez une liste déroulante indiquant « Choisir le modèle IA local ». Cliquez sur « Aller dans les paramètres » pour afficher les options d’IA.

Comment installer un LLM local

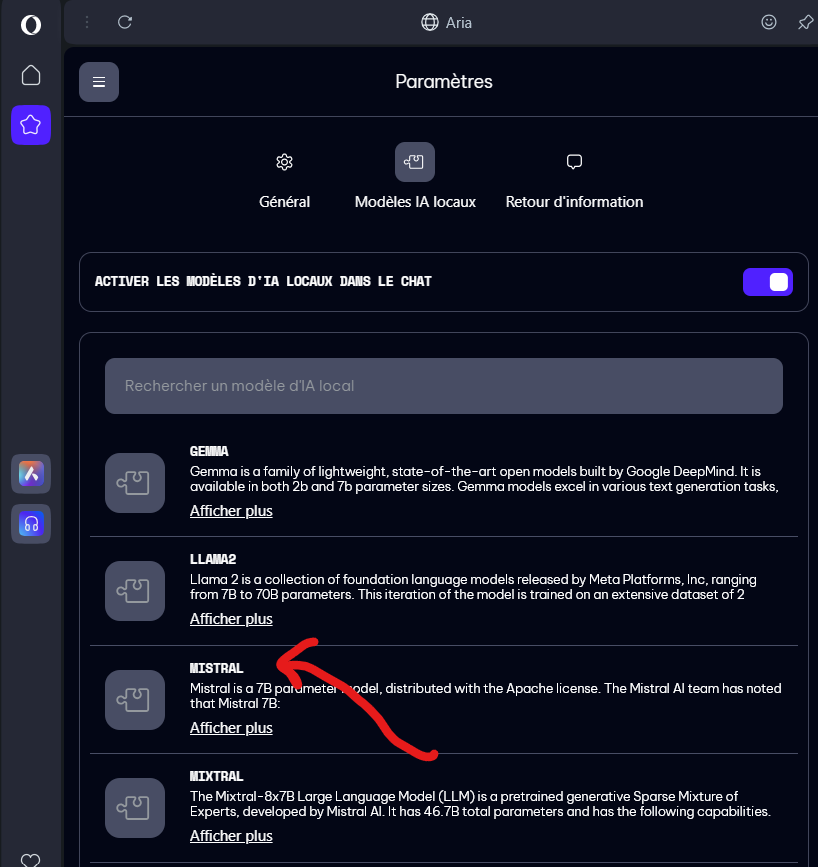

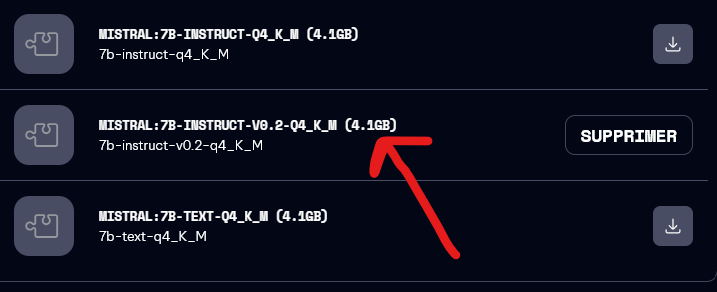

Dans les paramètres, vous pouvez parcourir et rechercher le modèle que vous souhaitez télécharger.

Par exemple, vous pouvez choisir MISTRAL:7B-INSTRUCT-V0.2-Q4_K_M (4.1GB) l’un des modèles les plus petits et les plus rapides, en cliquant sur le bouton de téléchargement à droite.

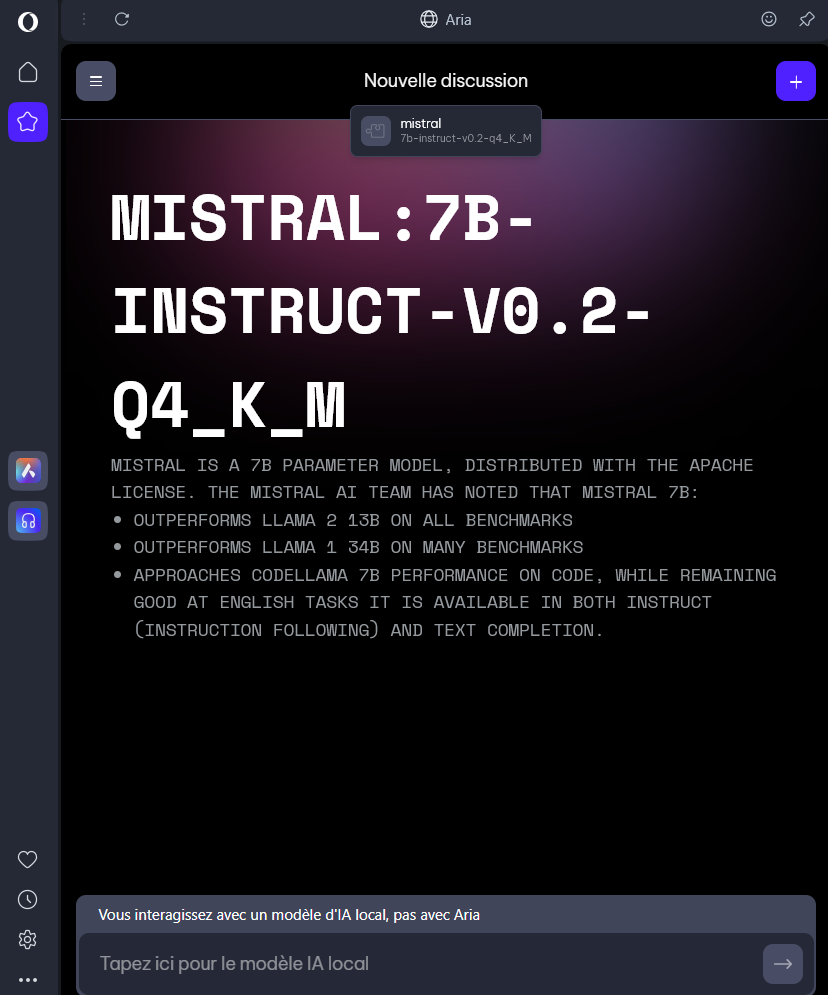

Une fois le téléchargement terminé, cliquez sur le bouton de menu en haut à gauche et démarrez un nouveau chat.

Comment chatter avec Mistral AI en local ?

En haut du chat, vous verrez à nouveau une liste déroulante indiquant « Choisir le mode local ». Sélectionnez le modèle que vous venez de télécharger.

Vous pouvez maintenant taper une invite dans le chat, et le modèle local répondra.

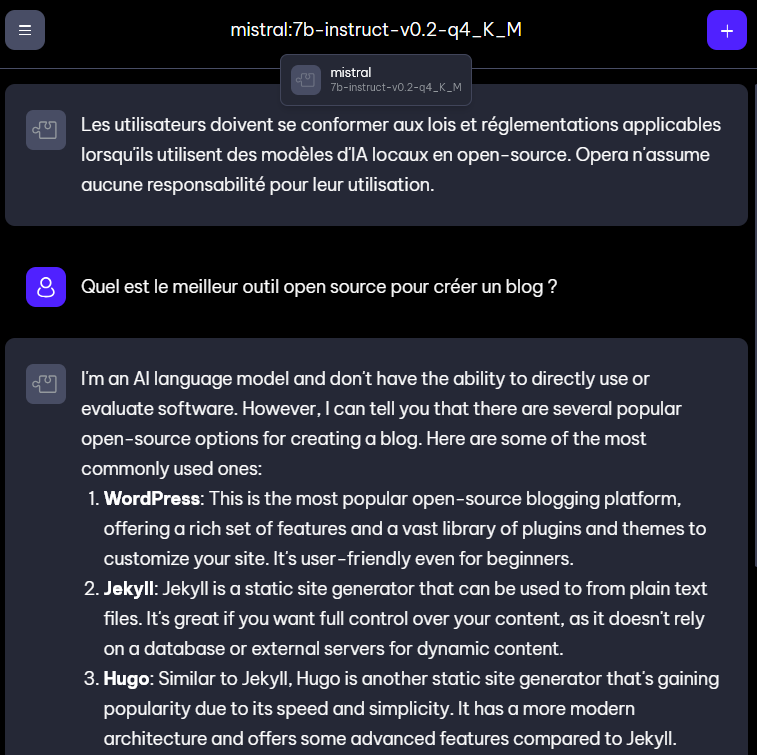

Ex: Quel est le meilleur outil open source pour créer un blog ?

Mistral 7B (4 Go) répond en anglais car il a été entraîné en anglais.

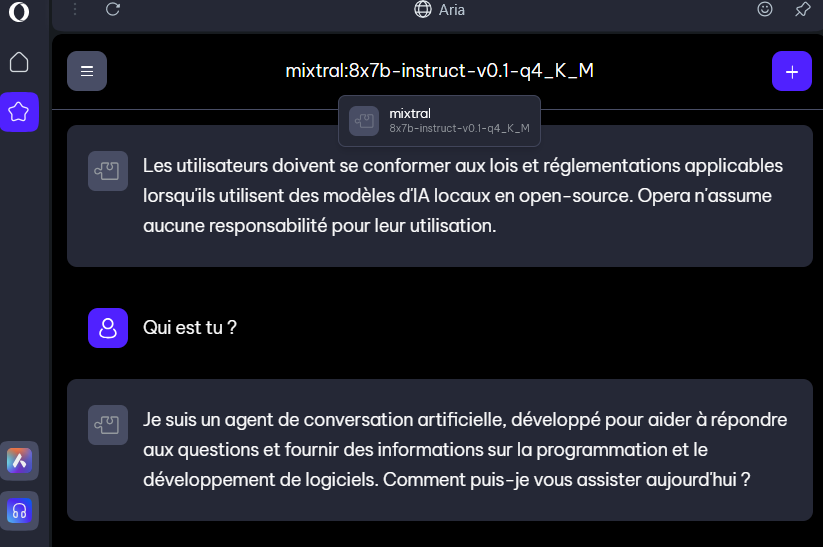

On peut aussi utiliser Mixtral 8x7B (24 Go) qui sait parler en français et est beaucoup plus costaud (semblable à ChatGPT 3.5), mais si vous avez une config légère, il sera très lent à répondre.

Les limites des LLM locaux sur Opera

Il est important de noter que chaque LLM local nécessite entre 2 et 30 Go d’espace de stockage local et qu’un LLM local est susceptible d’être considérablement plus lent dans la fourniture de sortie qu’un LLM basé sur un serveur, car il dépend des capacités de calcul de votre matériel.

Le LLM local sera utilisé à la place d’Aria, l’IA native du navigateur Opera, jusqu’à ce que vous démarriez un nouveau chat avec Aria ou que vous réactiviez simplement Aria.

Faut-il installer Opera One Developer ?

Si vous voulez une interface user friendly pour jouer avec des LLM locaux de petite taille, vous allez adorer Opera One Developer. L’outil se base sur Ollama qui est un peu compliqué à utiliser pour les non geeks.