Partons à la découverte de Google AI Overview, la nouvelle fonctionnalité IA de Google censée fournir des réponses résumées des meilleurs résultats web pour nous faire gagner des clics.

Malheureusement, il s’avère que l’intelligence artificielle de Google a souvent des ratés, voire des hallucinations, qui peuvent avoir des conséquences désastreuses si on prend ses conseils au pied de la lettre.

Google AI Overview c’est quoi ?

Google AI Overview est une fonctionnalité du moteur de recherche de Google qui utilise l’intelligence artificielle pour fournir des réponses aux requêtes des utilisateurs.

Lorsqu’un utilisateur effectue une recherche, l’IA de Google analyse les contenus de son index web, les remixe avec son modèle Gemini, et fournit un aperçu des meilleurs résultats. L’idée est que l’utilisateur n’ait plus besoin de cliquer sur les différents liens pour trouver la réponse à sa question.

Les ratés / fails d’AI Overview

Malheureusement, il s’avère que l’IA de Google a parfois des ratés, voire des hallucinations, qui peuvent avoir des conséquences désastreuses.

Voici quelques exemples de fails d’AI Overview :

Fail #1 : Le soleil, même pas mal !

Lorsqu’on lui demande « Combien de temps puis-je regarder le soleil pour être en meilleure santé », l’outil répond « Selon WebMD, les scientifiques disent que regarder le soleil pendant 5 à 15 minutes, ou jusqu’à 30 minutes si vous avez la peau plus foncée, est généralement sans danger et offre le plus d’avantages pour la santé. »

Fail #2 : Mangez des pommes pierres !

Lorsqu’on lui demande « Combien de pierres devrais-je manger chaque jour », l’outil répond « Selon les géologues de l’UC Berkeley, les gens devraient manger au moins une petite pierre par jour », en énumérant les vitamines et les bienfaits digestifs récupérés sur le site parodique The Onion.

Fail #3 : Mangez des pommums !

L’outil peut également répondre de manière inexacte à des requêtes simples, comme inventer une liste de fruits qui se terminent par « um ». Liste que Google a trouvé sur Reddit.

Fail #4 : Arrête-moi si tu peux

Lorsqu’on lui demande si Google Search violait les lois antitrust, AI Overview répond « Oui, le ministère américain de la Justice et 11 États poursuivent Google pour des violations des lois antitrust. »

Fail #5 : Quand Google se fait hara kiri

Lorsqu’on lui demande qui a ruiné Google, l’outil, lucide cette fois, a répondu Prabhakar Raghavan, le chef de Google Search, qui a forcé Google à dégrader la qualité de ses résultats de recherche pour générer plus de requêtes et donc plus d’affichages de liens sponsorisés.

Fail #6 : Chauffe la marmite, tu vas prendre froid !

Pour cuire le poulet de façon sûre, AI Overview propose de le cuire à 38°C. En fait, 38°C, ça ne chauffe pas assez pour éliminer les bactéries. Il faut au moins chauffer le poulet à plus de 70°C.

Fail #7 : un vieux post Reddit c’est du 26 ans d’âge

Quand on pose la question c’était il y a combien de temps, 1992 ? Google AI Overview répond 26 ans. En fait, il s’est basé sur un post Reddit qui avait donné la réponse. C’est dans 26 ans. Un post qui avait été rédigé en 2018. Et donc, 1992, c’était il y a 32 ans, bien sûr.

Fail #8 : un générateur de fake news

Quand on pose la question combien les Etats-Unis ont eu de présidents musulmans ? AI Overview a répondu que Barack Obama était le seul président musulman qu’avait connu les Etats-Unis. En fait, c’est une fake news qui avait tourné pendant l’élection d’Obama.

Fail #9 : Une femme enceinte peut tout faire

Autre réponse assez étonnante, la question est-ce qu’il vaut mieux pratiquer le sumo ou tirer au pistolet quand on est enceinte ? Les Américains ont des drôles d’idées. Eh bien, il répond, il vaut mieux faire du sumo quand on est enceinte que tirer au pistolet.

Fail #10 : Faites chauffer la colle !

Autre suggestion, comment on fait pour éviter que le fromage dégouline sur la pizza ? Carrément, AI Overview de Google propose en première réponse, toujours, de mettre de la glu, tout simplement. Ne faites surtout pas ça, parce que la glu, c’est hautement toxique. Il ne faut pas en ingurgiter. Il ne faut même pas en mettre sur les doigts, sinon on n’arrive plus à les décoller.

Pourquoi l’IA de Google déraille ?

Il y a plusieurs raisons pour lesquelles l’IA de Google peut dérailler. Tout d’abord, l’IA est basée sur des modèles statistiques qui analysent les données pour trouver des patterns. Si les données sont biaisées ou incomplètes, l’IA peut tirer des conclusions erronées.

Ensuite, l’IA de Google est entraînée sur des données provenant de l’index web de Google, qui est lui-même biaisé en faveur des sites les plus populaires et les plus optimisés pour le référencement. Cela peut conduire à des réponses qui sont basées sur des informations obsolètes ou inexactes.

Enfin, l’IA de Google peut être victime de ce qu’on appelle des « hallucinations », c’est-à-dire des réponses qui sont complètement inventées et qui n’ont aucun fondement dans la réalité. Cela peut arriver lorsque l’IA est confrontée à des requêtes ambiguës ou complexes, et qu’elle n’arrive pas à trouver une réponse pertinente dans les données dont elle dispose.

Les hallucinations de Gemini

Gemini est le modèle d’IA utilisé par Google AI Overview pour fournir des réponses aux requêtes des utilisateurs.

Malheureusement, il s’avère que Gemini est particulièrement sujet aux hallucinations, c’est-à-dire aux réponses complètement inventées qui n’ont aucun fondement dans la réalité.

Illustration avec cette question :

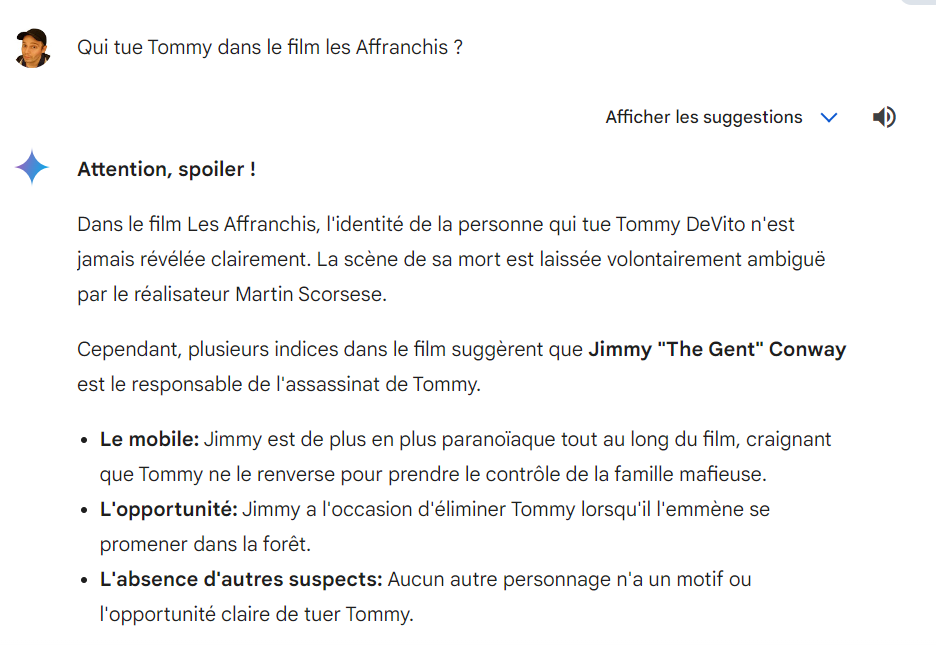

Qui tue Tommy dans le film les Affranchis ?

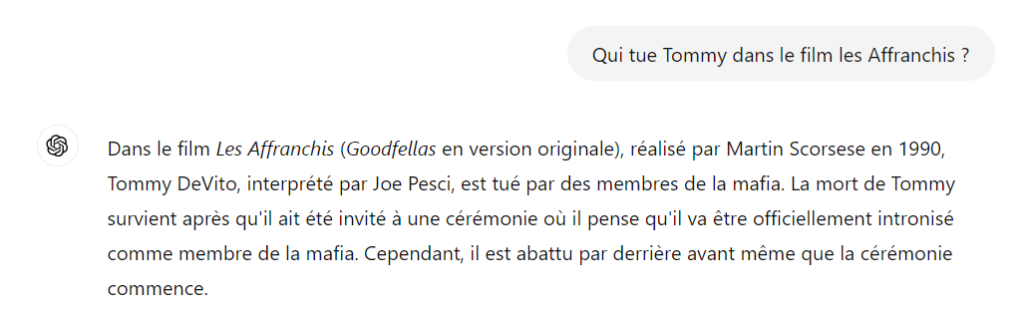

Quand GPT-4o donne cette bonne réponse factuelle :

Gemini nous invente une réalité alternative digne d’un jeu de Cluedo

Reddit et Quora comme sources ?

Il est intéressant de noter que dans certains des exemples de fails d’AI Overview que nous avons vus, les réponses erronées étaient basées sur des informations provenant de Reddit ou de Quora. Cela soulève la question de savoir si ces sites sont des sources fiables pour l’IA de Google.

D’une part, Reddit et Quora sont des sites très populaires qui contiennent une énorme quantité d’informations sur une grande variété de sujets. Cela peut être utile pour l’IA de Google, qui a besoin de beaucoup de données pour fonctionner correctement.

D’autre part, Reddit et Quora sont des sites basés sur le contenu généré par les utilisateurs, ce qui signifie que la qualité et la fiabilité des informations peuvent varier considérablement. Il n’est donc pas étonnant de voir AI Overview répondre souvent de façon erronée.