Mistral AI, le LLM made in France, vient de se doter d’une nouvelle fonctionnalité de chaîne de pensées / modèle de raisonnement : Magistral.

Tu peux la tester en ligne sur Le Chat (Magistral Medium) en cliquant sur Réflexion ou en local sur LM Studio si tu as une grosse machine (modèle Magistral Small).

C’est quoi un modèle de raisonnement ?

Lorsqu’il s’agit de faire des calculs simples ou de suivre des raisonnements, les Large Language Models comme ChatGPT, Le Chat, Claude n’y arrivent pas toujours, car ils sont entraînés à prédire des suites de mots logiques.

Grâce aux modèles de raisonnement, le LLM va prendre le temps de décomposer la question posée et sera ainsi plus à même de fournir LA bonne réponse.

Exemple ici pour le nombre de s dans saucissons :

Voici comment je procède :

- Je prends le mot « saucissons ».

- Je regarde chaque lettre une par une.

- Je compte combien de fois la lettre « s » apparaît.

Analyse du mot « saucissons » :

- S (1)

- A

- U

- C

- I

- S (2)

- S (3)

- O

- N

- S (4)

Donc, le mot « saucissons » contient 4 lettres « s ».

La chaîne de pensée Magistral est multilingue, transparente et ultra rapide

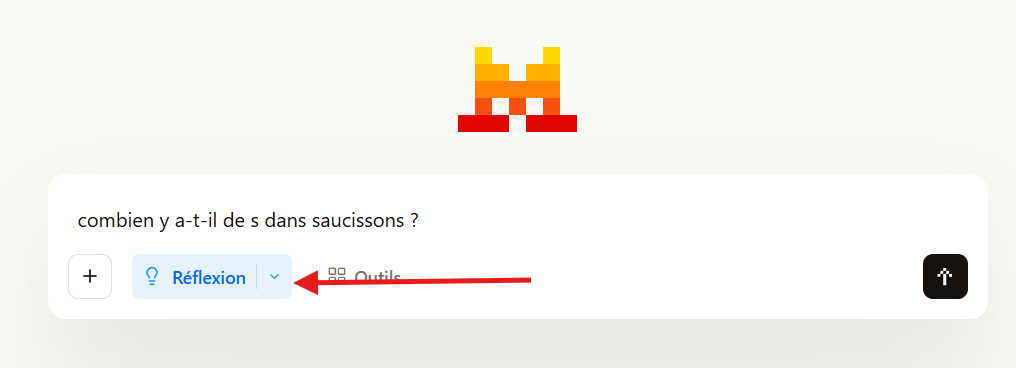

En cliquant sur le bouton « Réflexion » de Le Chat, tu vas pouvoir activer cette chaîne de pensées, qui consiste à dire au LLM de penser étape par étape.

L’avantage du modèle de raisonnement Magistral de Mistral est qu’il est affiché en français (ou dans d’autres langues) et ultra rapide à raisonner grâce au mode Flash proposé par Cerebras.

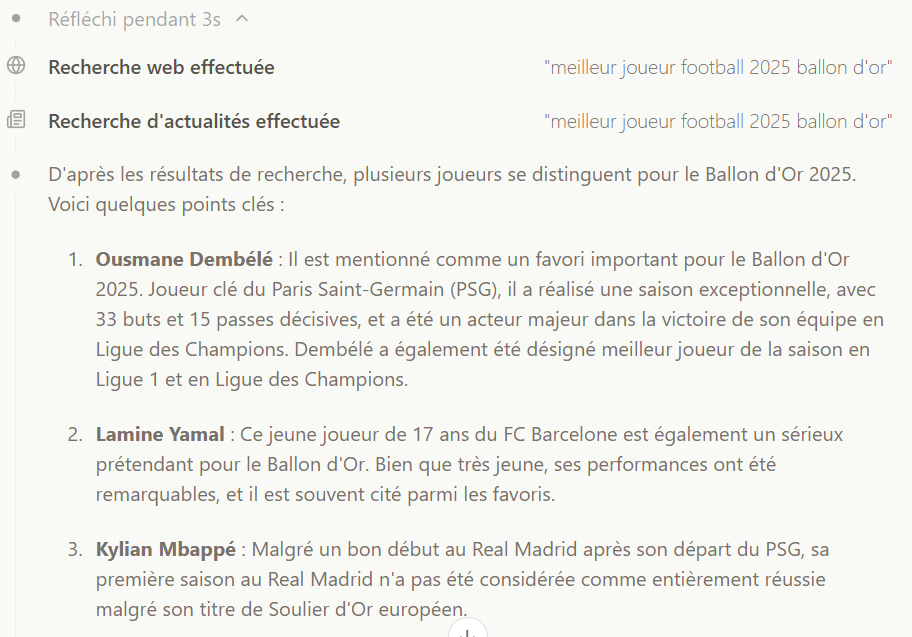

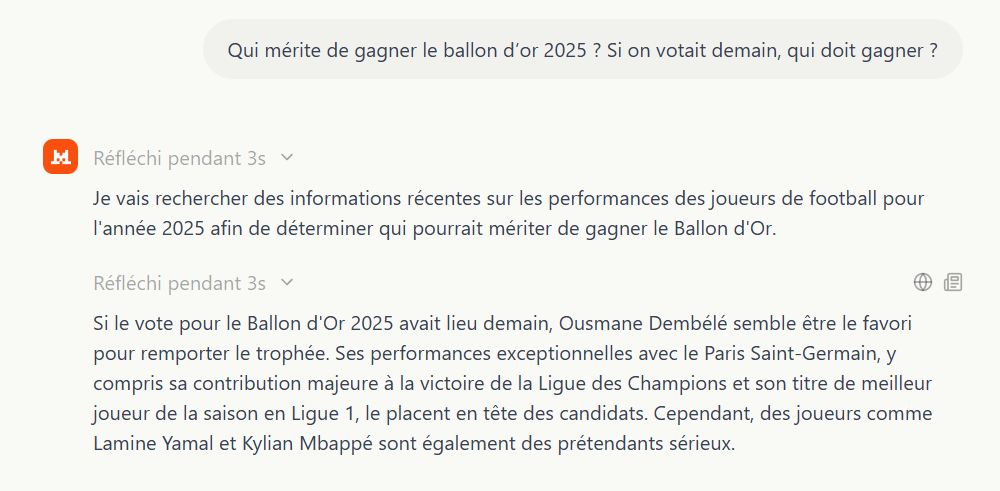

Exemple de chaîne de pensée affichée à la question « Qui mérite de gagner le ballon d’or 2025 ? Si on votait demain, qui doit gagner ? »

La réponse s’affiche en moins de 6 secondes

Quand d’autres modèles auraient besoin de plus de 10 secondes et n’afficheraient pas le raisonnement dans la langue d’origine de la recherche.

Comment tester Magistral en ligne ?

Voici une démo rapide pour tester Magistral sur Le Chat. Il suffit de cliquer sur le bouton « Réflexion ».

Comment tester Magistral en local sur PC ou Mac ?

Il est possible également de tester gratuitement en local grâce à LM Studio le modèle Magistral Small.

En revanche, si tu as un petit PC comme moi, ne t’attends pas à avoir des réponses très rapides. Le but ici est juste de montrer que ça fonctionne sans connexion Internet.

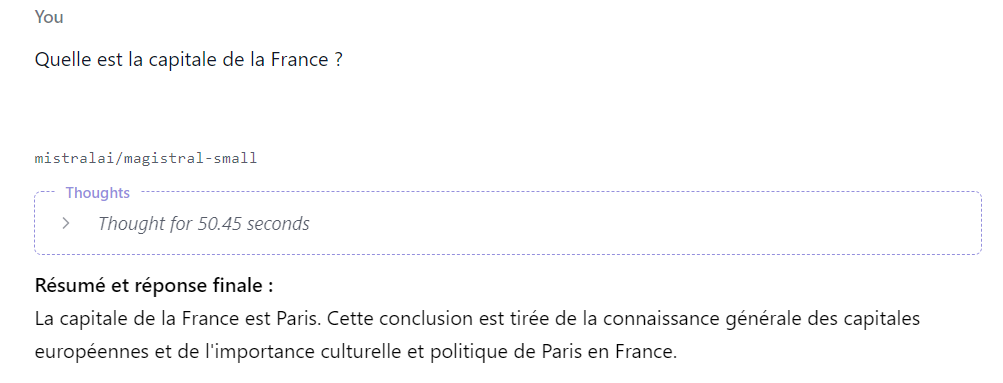

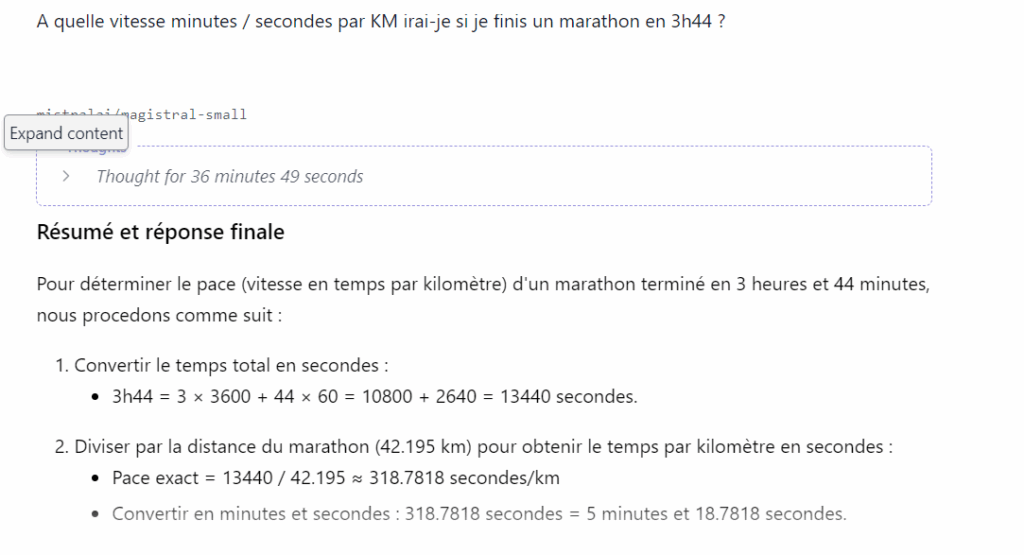

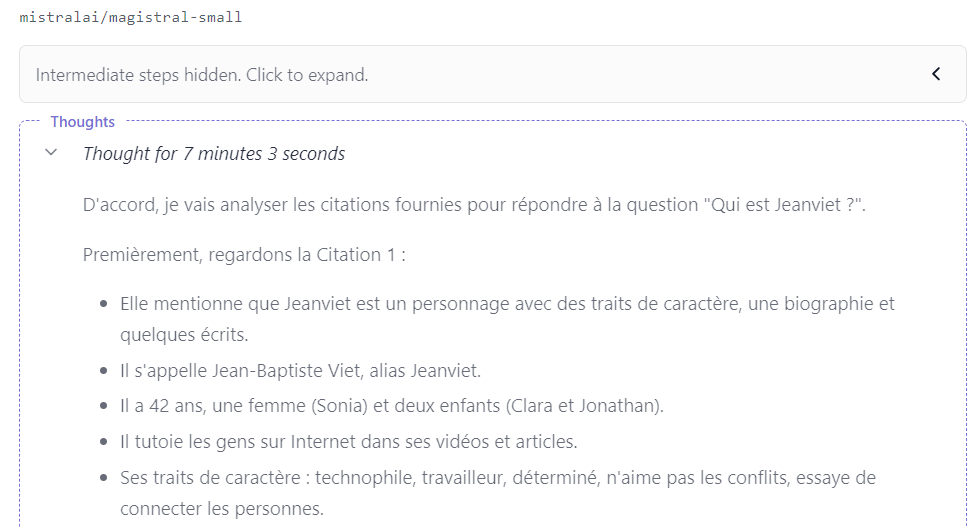

Voici quelques captures de recherches effectuées hier soir avec Magistral Small en local.

Certaines chaînes de pensée ont pris plus de 30 minutes à me répondre. Ce modèle aux 24 milliards de paramètres n’est clairement pas adapté à ma carte graphique de 6 go de VRAM.

J’espère qu’un jour Mistral pensera à ressortir un vrai petit modèle avec 8 milliards de paramètres comme Qwen 3 8b beaucoup plus adapté à mon petit PC ou Mac Mini M4.